In Noorwegen heb ik rotstekeningen gezien waarvan vermoed wordt dat deze ongeveer 9000 jaar oud zijn. Een van de tekeningen laat een rendier of hert zien dat zijn kop omdraait en achter zich kijkt. Niets bijzonders zou je denken. Maar iemand heeft dat beeld 9000 jaar geleden gezien, op de rots getekend en nu weten wij het. Dat is toch onvoorstelbaar. Hoe zit dat eigenlijk met onze moderne digitale gegevens, hoe lang kunnen wij die bewaren? Dit zette me aan het denken en als zo vaak leidt dat tot een stukje tekst.

Uiteindelijk vergaat alles

Om te beginnen, natuurkundig bekeken zal alles tenslotte vergaan. Zo hiermee is het meest voor de handliggende eerste gedachte van tafel.

Hoe lang kunnen we als mensheid eigenlijk analoge gegevens bewaren? Welke voorbeelden zijn er van overleveringen (analoog evenwel) en hoe oud zijn die eigenlijk? Kort onderzoek op internet levert het volgende overzicht op:

- Noorse rotstekeningen geschat 9000 jaar oud

- Kahun Gynaecological Papyrus geschat op 4000 jaar oud

- Gutenberg bijbel wordt geschat op 2000 jaar oud

- Gedichtenbundel van Den Schoolmeester in de boekenkast, geschat net iets minder dan 100 jaar oud

- Oudste foto in huis, mijn vader als kleine jongen, iets ouder dan 75 jaar

Mijn eerste observatie is dat ik vergeleken met de andere voorbeelden geen erg oude zaken in huis heb. Mijn tweede observatie is dat mits zorgvuldig bewaard papier aardig kan concurreren met rotstekeningen. We zouden dit als baseline kunnen beschouwen en eens kijken welke digitale media ik nog heb.

Digitaal archief

De eerste digitale media die ik zelf in huis haalde waren CD’s. Voor zover ik weet is de inhoud daarvan nog steeds goed leesbaar. In overzicht:

- Oudste CD (Kate Busch, Hounds of love) 30 jaar oud (het jaartal op het boekje)

- Floppy disc 19 jaar oud (er stond een datum op het label, de leesbaarheid kan niet geverifieerd worden, ik heb geen diskdrive meer)

- Oudste digitale foto 12 oud (ik wist nog waar en wanneer dat was, foto geverifieerd goed leesbaar)

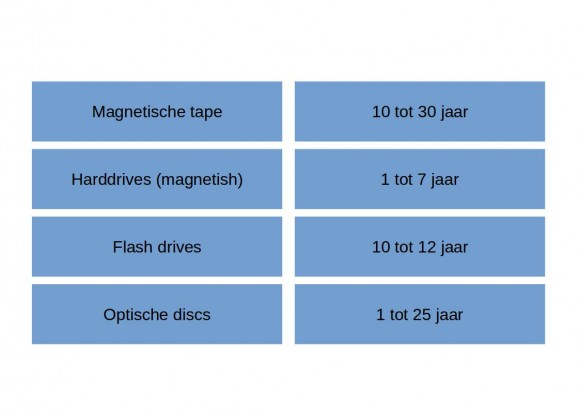

Vergeleken met de rotstekeningen en de eerste boeken is dit nog geen indrukwekkend resultaat. Hoelang gaan digitale media eigenlijk mee? Kort onderzoek op internet levert het volgende overzicht op.

Hoewel ik dit een wel erg voorzichtige inschatting vind, is het geen erg bemoedigend resultaat.

Digitaal versus analoog

Er is blijkbaar een belangrijk verschil tussen het opslaan van gegevens in analoge vorm en in digitale vorm. In het geval van analoge gegevens kan je stellen dat de levensduur van de gegevens gelijk is aan die van het materiaal (de media) waarop ze zijn opgeslagen. Voor digitale gegevens gaat dit niet op. Een tape of floppy kan zijn gegevens verloren zijn zonder dat je dat kan zien. Daarnaast moet het het medium nog kunnen lezen (heb je dan nog een werkende floppy drive of CD speler en interface?).

Er wordt wel gesteld dat media na twee generaties systemen niet meer leesbaar zijn.

Daarnaast moet het format van de bestanden ook nog leesbaar zijn. Deze zaken worden wel aangeduid met fysical media obsolescences. Naast deze digital obselescence speelt er nog een andere complicerende factor, namelijk datagroei. De groei van data is niet lineair, maar eerder exponentieel.

Welke factoren beïnvloeden digitale opslag media? Te denken valt aan magnetische invloeden, temperatuur (zowel hitte als kou), brand, radiostraling, vocht, uitdroging, chemicaliën en fysieke invloeden (aardbevingen, instortingen van gebouwen e.d.)

Aanvalsplan

Bedrijven en organisaties zien zich natuurlijk eveneens geconfronteerd met deze problematiek, daar zijn we bij ons in huis met onze muziek, foto’s en home video’s geen uitzondering op. Welke tactiek(en) passen deze bedrijven toe?

Het fysiek handelen van mensen doet de media sterk doet achteruitgaan en heeft daarom grote risico’s. Om dit tegen te gaan worden bijvoorbeeld robot’s gebruikt om tapes te hanteren.

Het labelen van CD's en DVD's verminderd de houdbaarheid van sterk.

Ook wordt data wel herschreven (ververst). Hiermee wordt datarot (ook wel bitrot genoemd) tegengegaan. Ook wordt ervoor gekozen data naar nieuwe media te migreren.

Datarot, het vervagen onleesbaar worden van digitale gegevens op een drager of in memory.

In alle gevallen wordt geaccepteerd dat een deel van de gegevens verloren gaat. Dat is dus niet anders dan ik de fysieke (analoge) wereld.

Misschien een vreemd idee, maar digitale gegevens op papier printen kan een oplossing zijn voor de eeuwigheid. We weten immers dat dit duizenden jaren kan overleven. Bovendien is er daarmee ook geen afhankelijkheid van gebruikte interfaces. Het is echter minder handig als het gaat om de opslag van veel gegevens. Daarmee vallen foto’s, muziek en film praktisch af.

De keuze voor rotstekeningen was dus nog zo slecht niet. Alle respect voor de kunstenaar van 9000 jaar geleden.